Parlare fra sé e sé, un’azione quasi intermedia fra il pensiero e la comunicazione vera e propria, è spesso un’abitudine. Per non perdere le nostre vocalizzazioni interne, che possono contenere idee e concetti importanti, oggi un nuovo strumento di intelligenza artificiale consente di rilevarle e trascriverle su schermo . A metterlo a punto è un gruppo di ricercatori del Mit Media Lab. Così, mentre studiamo, cuciniamo, siamo intenti nel lavoro o in altre attività, questo sistema, chiamato AlterEgo, consentirebbe di non perdere le nostre conversazioni silenziose e di metterle per iscritto, ad esempio sul pc o su altri dispositivi digitali. I risultati sono stati presentati alla 23esima International Conference on Intelligent User Interfaces dal gruppo del Mit Media Lab.

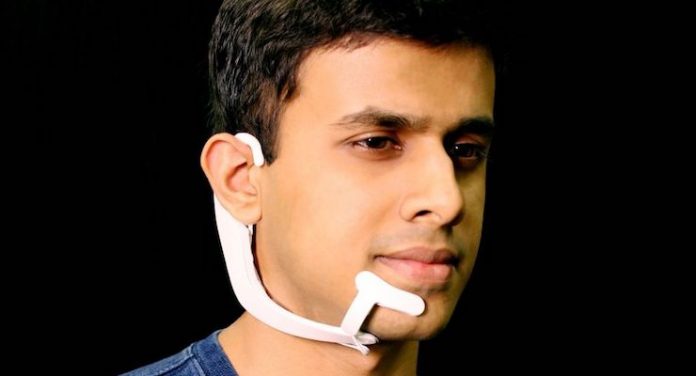

Il sistema è costituito da un dispositivo indossabile, che si appoggia sull’orecchio e segue la mandibola. Questa sorta di cuffia-microfono hi-tech si collega, senza fili, ad un sistema di calcolo basato sul machine learning, cioè un insieme di metodi di apprendimento automatico (che rientrano nei sistemi di intelligenza artificiale), i quali riportano per iscritto le conversazioni fra sé e sé della persona.

L’idea di studiare le vocalizzazioni interne, o sotto-vocalizzazioni, nasce nel ‘900, ma viene approfondita soltanto a partire dagli anni ’50. Uno dei risultati più importanti, negli anni ’60, all’interno dello speed-reading, cioè della trascrizione della lettura veloce, fu quello di eliminare queste sottovocalizzazioni.

Il modello hi-tech odierno, invece, mette a fuoco proprio le conversazioni secondarie e silenziose. Per farlo, si fonda su analisi acustiche molto sottili: alcuni elettrodi rilevano i segnali neuromuscolari nella mandibola e sulla faccia, attivati proprio dalla verbalizzazione interna.

Gli autori hanno chiesto a un gruppo di 10 partecipanti di riprodurre più volte una serie di parole, individuando tramite elettrodi i punti del viso in cui questi segnali erano più riproducibili e potevano essere colti con maggiore facilità. Una volta selezionati questi snodi facciali, hanno raccolto dati di brevi frasi di circa 20 parole, una contenente calcoli di aritmetica(addizioni e moltiplicazioni) e una le mosse degli scacchi. Raccolti i dati, poi, hanno utilizzato un network neurale che ha consentito di individuare le associazioni fra i segnali neuromuscolari e le parole associate. In questo caso, l’accuratezza, cioè la precisione, nella trascrizione, è stata pari al 92%. E si può fare ancora di più, includendo un numero maggiore di vocaboli utilizzabili e raccogliendo più dati.

Le applicazioni di questo sistema di intelligenza artificiale potrebbero essere molteplici. Per esempio, per utilizzare le app sui dispositivi mobili e cercare informazioni si deve distogliere l’attenzione dall’attività che si sta svolgendo per digitare la richiesta ad esempio sul cellulare. Così, il team di ricerca ha voluto sperimentare nuove modalità di utilizzo della tecnologia senza dover interrompere ciò che si sta facendo. Oppure, quando ci si trova in ambienti silenziosi e non si può parlare a voce alta. Altre applicazioni specifiche e utili, secondo gli autori potrebbero essere cuffie per i controllori dell’atterraggio degli aerei, situazioni in cui vi è frastuono e non si riesce bene a comunicare. Ma potrebbe essere d’aiuto anche per persone che hanno una patologia per cui non riescono a parlare normalmente, ad esempio pazienti con un tumore che ha colpito le corde vocali e che potrebbero beneficiare di un sintetizzatore (in questo caso vocale e non per iscritto) che si impegni per loro.

Via: Wired.it